| Сообщество uCoz Вебмастеру Раскрутка сайта Google Вебмастер Google инструменты для веб-мастеров (путеводитель по вебмастеру Гугла) |

| Google инструменты для веб-мастеров |

Если вы создали сайт в системе uCoz и на сайте закончился карантин, то вам нужно сообщить о своем сайте поисковым системам. Это можно сделать с помощью Инструментов для веб-мастеров Google. У вас должен быть аккаунт в поисковой системе Google, если нет, то сразу создадите аккаунт. По этой ссылке вы можете войти в панель вебмастера или зарегистрировать аккаунт На главной странице панели вебмастера вы можете добавить свой сайт. После добавления вы должны подтвердить права на него.  Подтверждение прав на сайт:

Панель вебмастера Google: На главной странице выводится три панели с информацией и "Новое и важное" (сообщения о критических ошибках и предупреждения если есть):

Внимание! Добавлять карты сайта нужно не вставляя сам адрес сайта, адрес гугл подставляет сам! Вы должны добавить только /sitemap.xml и /sitemap-forum.xml Примечание! Информация об отправленных url и url в интернет-индексе всегда различна. Последний показатель может быть меньше числа отправленных. Это нормально  Полезные инструменты:

Как видите панель вебмастера Google может дать очень много полезной информации. Примечания: 1. Если вы добавили новый не проиндексированный сайт, то информация в панели появится в течение первого месяца 2. Выводимая тех. информация во всех панелях может изменяться с запозданием |

|

Здравствуйте! Помогите решить проблему, почему гугл заблокировал у меня так много URL 7 327

В течение последних 90 дней робот Google пытался просканировать эти URL, но был заблокирован посредством файла robots.txt. Скрин мой robots.txt что в нём не так?, я его не менял сайту 7 месяцев. User-agent: * Disallow: /a/ Disallow: /stat/ Disallow: /index/1 Disallow: /index/2 Disallow: /index/3 Disallow: /index/5 Disallow: /index/7 Disallow: /index/8 Disallow: /index/9 Disallow: /panel/ Disallow: /admin/ Disallow: /secure/ Disallow: /informer/ Disallow: /mchat Disallow: /search Disallow: /shop/order/ Disallow: /?ssid= Disallow: /abnl/ Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap-forum.xml Sitemap: http://site.ru/sitemap-shop.xml |

|

|

|

Я не нащёл как в веб-мастере гугла посмотреть какие URL заблокированы, написано только то, что 6 858 URL заблокировано. Добавлено (15 Фев 2014, 13:08:35) |

|

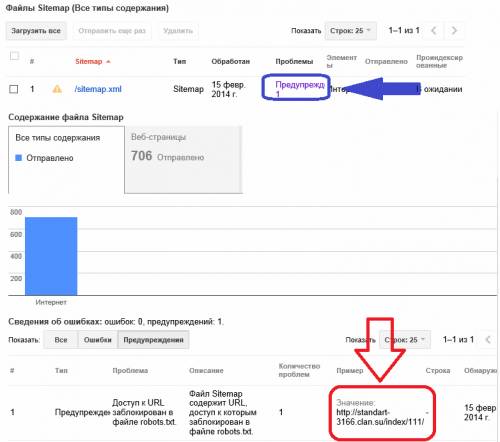

esc1587, По синей стрелке ссылка, переход (верхняя часть изображения), в другом окне (нижняя часть) выделена причина красным

Попробуйте обновить файл ... Прикрепления:

4014273.png

(18.5 Kb)

Сообщение отредактировал Miss_Esq - Суббота, 15 Фев 2014, 13:34:34

|

|

esc1587, ссылку на сайт надо додуматься дать. по скринам тут только мисс гадает. и то, только по своим

|

|

|

|

esc1587, Гадать там нечего, анализировать нужно и содержание сайтмапа и проблемные адреса, заблокированные в google. Проблема с адресами самими ... У меня была заблокирована тестовая страница только из за цифры 111 в ЧПУ URL ....

|

|

Добрый день, форумчане.

Вот такая трабла у меня уже давно В гугл мастере вот такие цифры уже месяц. меняется только "URL отправлены", а "количество проиндексированных URL" не меняется. 3 505 URL отправлены 2 164 – количество проиндексированных URL Я где то в декабре купил домен .ru на этот сайт и после этого пошло не так. То что должно было произойти снижение посещаемости это я был в курсе. Но при сканировании страниц с новым доменом цифра остановилась на 2 164 и дальше никуда. сайт http://filmodok.ru Подскажите пожалуйста что можно исправить или сделать чтобы вернулось все на круги своя. До смены домена все шло стабильно. |

|

Из-за перенесения материалов из одной категории в другую, появились дубли по обоим адресам. Я принял меры для устранения будущих дублей, но старые все так же продолжают висеть в индексе. Подскажите, стоит ли удалять ненужные дубли при помощи функции в вебмастере "Удалить URL-адреса".

Неоднократно читал, что при удалении дублей, робот удаляет и основную страничку: пруф Цитата Не используйте инструмент удаления URL для удаления нежелательных версий URL. Это вам не поможет сохранить предпочтительную версию страницы. Ведь при удалении одной из версий URL (http/https, с префиксом www или без него) будут удалены и все остальные. The Cake Is a Lie

|

|

Vintash, у вас уже конкретный пунктик с этими дублями. отчего лично вы так боитесь этих дублей? поясните

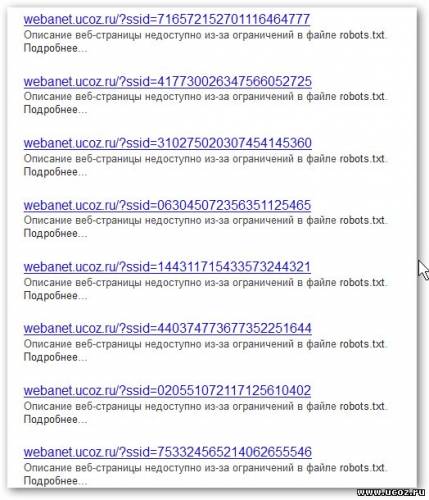

нет не стоит. надо помнить, что если гугл однажды проиндексировал страницу, то он её держит в выдаче до потери вашего сознания. по большому счету заставить удалить страницу из выдачи можно только с помощью инструмента удаления урла или с помощью параметров урл в инструментах (с относительным успехом). а самый эффективный способ избавиться от проиндексированной страницы - это удаление этой страницы с сайта. вот тогда гугл порежет страницу в выдаче с гарантией в 100%. нет в 300% не надо рефлексировать и путать теплое с мягким. сейчас скажу крамольную вещь, но гугл к естественным дублям cms относится нормально. одну из страниц он может держать в общей выдаче, все остальное он просто припрячет в сопли, которые не делают погоды для основной страницы. плохо гугл относится только к искусственным дублям. только тогда можно получить санкциями по всей группе страниц. грубый пример искусственных дублей. у вас есть три одинаковые страницы. одинаковые титлы. одинаковые мета-описания. одинаковое содержание, но в конце каждой страницы стоит например ссылка на другой сайт и на каждой странице разная. вот за такое можно получить по голове. это грубый пример. и вот, чтобы защитить сайт от гнева машины гугл принимает каноникал https://support.google.com/webmasters/answer/139394?hl=ru читаем первые строчки толмуда Цитата Что такое каноническая страница? Каноническая страница – это рекомендуемый экземпляр из набора страниц с очень похожим содержанием. читаем как это работает Цитата Если Google будет знать о том, что содержание этих страниц одинаково, то сможет добавить в результаты поиска только одну из них. Наши алгоритмы выбирают ту страницу, которая, по нашему мнению, лучше всего отвечает на запрос пользователя. Тем не менее, теперь пользователи могут указывать поисковым системам каноническую страницу, добавив элемент <link> с атрибутом rel="canonical" в раздел <head> неканонической версии страницы. Добавление этой ссылки и атрибута позволяет владельцам сайтов определять наборы идентичного содержания и сообщать Google: "Из всех страниц с идентичным содержанием эта является наиболее полезной. Установите для нее наивысший приоритет в результатах поиска". в случае же с естественными дублями cms и без каноникала гугл уже будет рулить сам и выбирать из набора одинаковых страниц, по его мнению самую отвечающую данному запросу. все. теперь по роботсу наглядный пример в картинках как видим несмотря на запрет в роботсе, который гугл подтверждает. несмотря на комплекс удушающих мер в параметрах урл. то что робот взял давным давно, он упорно держит уже более года. единственное к чему привела жестокая борьба с машиной - это удалось отвадить робота от сканирования все новых и новых ссидов. удалить параметрами урл не удалось. а вот с прекращением сканирования подобного вышла победа. в параметрах стоит 4!!! экземпляра примеров Цитата Из-за перенесения материалов из одной категории в другую, появились дубли по обоим адресам. поэтому успокойтесь. перестаньте бороться с ветряными мельницами. наполняйте и развивайте сайт и не занимайтесь ерундой Прикрепления:

2540925.jpg

(85.9 Kb)

|

|

webanet, ого, такого развернутого ответа я, честно сказать, не ожидал

Получается я зря прописывал canonical в шаблонах? Вот теперь не знаю, вдруг он еще и навредит... Как думаете, хорошо или плохо, когда в дублях статьи прописан каноникал на основную ссылку материала? The Cake Is a Lie

Сообщение отредактировал Vintash - Суббота, 08 Мар 2014, 21:47:56

|

|

Vintash, вижу, что вы нашли новую ветряную мельницу. оставьте.

я это написала тут для того, чтобы вы занялись сайтом наконец и чтобы тут не появилось 100500 тем вашего пера с вечными апами а-ля а когда выпадут дубли из индекса? на счет дублей переноса я добавила в свою портянку. по остальным вопросам вам придется страдать дальше ибо для того чтобы ответить точно хорошо вы сделали или плохо лучше всего иметь адрес сайта чтобы проверить. но это строгий секрет. вот и секретничайте |

|

Vintash,

Цитата Вот теперь не знаю, вдруг он еще и навредит...  потом расскажите результат ... потом расскажите результат ... |

| |||

Чат сообщества

Чат сообщества