| Модератор форума: Yuri_G |

| Сообщество uCoz Вебмастеру Раскрутка сайта Раскрутка и оптимизация сайтов (рекомендации) |

| Раскрутка и оптимизация сайтов |

|

Раскрутка сайта - первые шаги:  Созданный сайт в системе uCoz находится на карантине. Созданный сайт в системе uCoz находится на карантине.Карантин - это блокировка индексации сайта через Robots.txt Robots.txt сайта на карантине выглядит так: User-agent: * Disallow: / Robots.txt сайта на карантине изменить невозможно. После снятия сайта с карантина Robots.txt можно изменять. Автоматически карантин можно снять оплатив пакет услуг Базовый и выше Подробнее о карантине и как его снять и системном файле Robots.txt Сайты находящиеся на карантине добавлять в поисковики и в вебмастера Яндекса и Google не нужно!  Сайты снятые с карантина нужно добавить в вебмастер Яндекса и Google Сайты снятые с карантина нужно добавить в вебмастер Яндекса и GoogleGoogle инструменты для веб-мастеров Яндекс Вебмастер Создать аккаунты в вебмастере Google и Яндекса и добавить сайты через формы В поисковик сайты можно добавить и через специальные формы Добавить сайт в Яндекс Добавить сайт в Google предпочтительнее добавлять из вебмастера  Подтверждение прав на сайт в вебмастере Яндекса и Google Подтверждение прав на сайт в вебмастере Яндекса и GoogleПосле регистрации в вебмастерах поисковиков и после добавления сайта в поисковик и в свой аккаунт вебмастера нужно пройти процедуру подтверждения прав на сайт. Лучше всего выбрать метод проверки Мета-тег Яндекс и Google генерируют проверочный мета-тег, код которого нужно вставить в код главной страницы сайта Пример вставки кода: Код <head><title>Название вашего сайта</title> <meta name="verify-v1" content="yyruutyegg689596ngj569995b4="> <meta name='yandex-verification' content='6tyy47758867774ghbbhgfjkd' /> <link type="text/css" rel="StyleSheet" href="/_st/my.css" /> Первый мета-тег от Google, второй от Яндекса. Ставить сразу после Код <head><title>$SITE_NAME$ - $MODULE_NAME$</title> Псле установки проверочного мета-тега нужно инициировать проверку и в Яндексе и в Google  Sitemap карта сайта. Sitemap карта сайта.Подробней о карте сайта Карты сайта автоматически генерируются системой и ручного создания не требуют. Ссылки на карты сайта можно получить так: панель управления - поиск по сайту - адреса sitemap файлов. Системой автоматически генерируется 3 карты сайта. Карта сайта, карта форума и карта интернет-магазина. Карты сайта используемых модулей нужно передать в вебмастер Яндекса и Google через специальные формы. Внимание! В форму добавления карты Яндекса нужно вставлять полный адрес http://ваш сайт.ru/sitemap.xml В форму добавления карты Google нужно вставлять только /sitemap.xml а адрес вашего сайта Google подставляет сам  Индексация сайта. Индексация сайта.Индексация сайта начинается после снятия карантина и добавления сайта в поисковики. Индексация занимает некоторое время. Иногда ожидание может затянуться. Если после снятия карантина и добавления в поисковики и вебмастера сайт на протяжении более 2 месяцев не появляется в поиске, то нужно обращаться в поддержку через вебмастер. В Яндексе это обращение Платонам, в Google можно подать сайт на пересмотр Сайт может не попасть в индекс по причине наложения фильтра и бана или по техническим причинам.  Раскрутка сайта. Чего делать не стоит Раскрутка сайта. Чего делать не стоитМолодой сайт практически не наполненный контентом не стоит сразу прогонять по сотням тысячам каталогов. Это распространенное заблуждение, что раскрутка сайта - это прогон по каталогам, и чем больше - тем лучше. Если и тянет к каталогам, то можно найти весомые незабаненные поисковиками несколько каталогов и зарегистрировать там сайт. При создании дизайна или при правке элементов дизайна не допускайте на сайт попадания сторонних ссылок. Не вставляйте на сайт скрипты и графику с чужими адресами. Заливайте все к себе на сайт. Если вы используете сторонние шаблоны, то проверяйте код шаблонов на спам вставки. Пример: Код <a href="http://спам-адрес сайта.ru title="спам" style="display:none;">текст-описание.</a> Сократите до минимума количество внешних ссылок на своих страницах Ещё одна обидная ошибка на молодых сайтах - это огромное количество счетчиков и всяких рейтингов, а так же информеров и кнопок с нулевым Тиц и PR. Молодому сайту это все не нужно. Это внешние ссылки и ненужная статистика того чего нет. Если посещаемость сайта меньше количества счетчиков и кнопок, то стоит задуматься нужны ли они вообще Уникальность контента. Если на вашем сайте весь контент полностью скопирован с чужих сайтов буква в букву, то в поисковой выдаче стоит искать свой сайт не с первых страниц выдачи, а сразу начинать с последних, так вы найдете свой сайт быстрее по ключевым словам. В идеале весь контент должен быть уникальным, но такое встречается редко. Поэтому хотя бы 60% уникального контента будет достаточно, чтобы начать искать свой сайт с другой стороны выдачи. Эта тема для тех, кто хочет поделиться своим опытом по раскрутке сайтов. Сюда пишем небольшие самостоятельно написанные статьи-инструкции.

Всё не соответствующее теме будет стираться.За рекламу пользователи будут баниться на 10 дней . |

|

Вопрос: Ребят подскажите по одному вопросу:слышал разговоры что если на сайте установлена Pop-under реклама,то гугля начинает плохо индексировать,вот и хочю развеять свои сомнения

Ответ:, 3.16.7. Запрещается склонять пользователей к осуществлению переходов по обязательной рекламе, накручивать показы/переходы по ней любыми другими средствами. Это из правил Юкоз |

|

Quote (Diоm) Зарегистрировал сайт в поисковиках больше недели назад, до сих пор не проиндексированно ни одной странички. Это нормально? Во-первых, смотря как зарегистрировал. Если через страницу "добавить URL" - то такое добавление имеет очень низкий приоритет, а вот если через добавление сайта в свою панель вебмастера - то наоборот высокий. Обычно главная страница после добавления в панель вебмастера начинает показываться очень быстро (иногда в тот же день, или по крайней мере через 2-3 дня), а вот другие начинают появляться в индексе только через 1-2 недели. Но у меня, например, ни одной страницы не появлялось в индексе Яндекса аж целых полтора месяца, и саппорт Яндекса отвечал только "ждите, все нормально". Так что бывает по-разному. Потеряшка - поиск потерянных и помощь бездомным животным в Питере

Сообщение отредактировал YuriT - Среда, 02 Мар 2011, 17:30:52

|

|

Quote (max28) Я бы установил и вылетел из яндекса, как ГС Основные ошибки веб-мастеров 1. Семантика. 1.1. при составление семантического ядра, для сайта, 80% вебмастров используют стоп символы в теге <title>, это ()-=/ \! |+_ 1.2 столько же вебмастеров ставят в <title> название компании, здесь имеет смысл это делать если вы являетесь БРЭНДОМ, но если вы маленькая компания, то для этого можно использовать страницу контактов, и в 99% случаев - эта страница выйдет на 1-е место по запросу "название вашей компании", и пользователь ищет по такому запросу именно вашу контактную информацию. 1.3. 70% вебмастеров в <meta name="Description" content=""> ставят набор ключевых слов 1.4 CSS и Java(Script) надо выносить в отдельные файлы, и ваш значимый контент окажется выше в коде, и поисковику меньше работы. 1.5 H1 ну тут у многих разные фантазии от "Добро пожаловать" до "Компания такая то", ну то что по этим словам вас никто, или почти никто искать не будет, это факт. 1.6 а больше всего удивило что 90% игнорируют <img alt>. 1.7 при составлении семантики основная часть веб-мастеров использует много высокочастотных запросов, так и низкочастотных. Вывод: при составлении семантического ядра надо отнестись со всей тщательностью к подбору этих ключевых слов и к расстановке их по нужным тегам, и составлению контента. 2. HTML 2.1 пару раз встречались перлы <a hreh=""><h1> и <h1><stong> это явные ошибки. 2.2 ну и пару раз встретилось <h1><font> во первых здесь вложенность в тег <h1>, во вторых есть CSS. 2.3 и один раз встретилось меню на Java(Script) соответственно в поисковиках была только главная страница, в таких случаях помогает карта сайта. Очень часто сейчас стали встречаться люди, которые начитавшись форумов устраивают прогоны по каталогам, но не разобравшись в вопросе заказывает это дело, а составление проекта отдается на откуп прогонщика, и после этого получают либо тошноту анкора, либо много-много копий своего контента, либо того и другого, в итоге получают фильтры и баны. спасибо в репутацию

Сообщение отредактировал SPARTАCUS - Воскресенье, 21 Ноя 2010, 16:43:58

|

|

Quote (Антарис) Кто нибудь может подсказать программу, которая проверяет уникальность написанной статьи? Мне понравился онлайн-сервис проверки на уникальность вот здесь: Потеряшка - поиск потерянных и помощь бездомным животным в Питере

|

|

Вопрос: вопрос про дубликаты страниц. google говорит что на сайте дубли например /news/2010-04-27-146 и /news/2010-4-27-146-0- , и при чем несколько таких дублей. как убрать не нужное

Ответ:, если конкретно по поводу страниц такого типа - то для запрета таких дублей лично я прописал себе в robots.txt строчку Disallow: *-0-$ Потеряшка - поиск потерянных и помощь бездомным животным в Питере

|

|

Quote (Labirint82) Атрибут rel="nofollow" только по Google запрешает передовать PR страницы. Это бывает полезно когда хотите накопить вес на странице. Не только по Гуглу. Яндек теперь тоже учитывает nofollow. А вот noindex уже ссылки полностью не экранируют - во всяком случае, теперь Яндекс показыват ссылки, скрытые в noindex, в списке внешних ссылок на сайт. Потеряшка - поиск потерянных и помощь бездомным животным в Питере

|

|

Вопрос:,

Quote (Admin5411) если я закрыл для гостей просмотр материалов, то и поисковики не смогут индексировать материал, или они с правами пользователей проводят индексацию? Ответ: Не смогут. поисковики просматривают сайт с правами готей, поэтому то что видит гость - то видит и поисковик |

|

Для информации: недавно Яндекс опубликовал 19-страничный мануал с советами по созданию и оптимизации сайтов. Рекомендуется просмотреть.

Мануал доступен для скачивания здесь: http://help.yandex.ru/webmaster/?id=1108938 Потеряшка - поиск потерянных и помощь бездомным животным в Питере

|

|

Приветствую всех.

Столкнулся при продвижении сайта с такой проблемой - к каждой новости у меня прописан свой дискрипшн и гугл берёт его в сниппет, но в выдаче гугл всегда в начале сниппета ставит дату (наверное время добавления материала) - *13 июня 2011 – мой прописанный дискрипшн*. Вопрос - откуда он берёт эти даты и как сделать так, что бы убрать их? p.s. Сейчас глянул, яндекс тоже обязательно в подписе к ссылки на сайт пишет дату.  Сообщение отредактировал Ejikc - Среда, 29 Июн 2011, 18:08:47

|

|

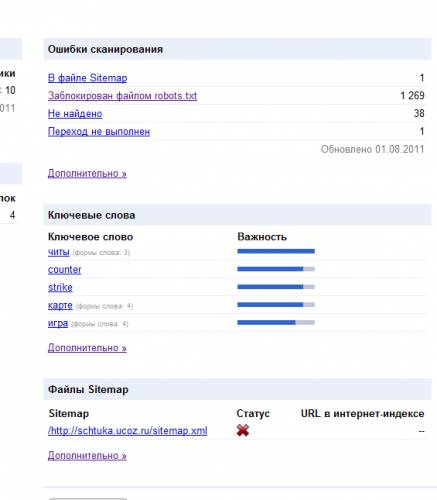

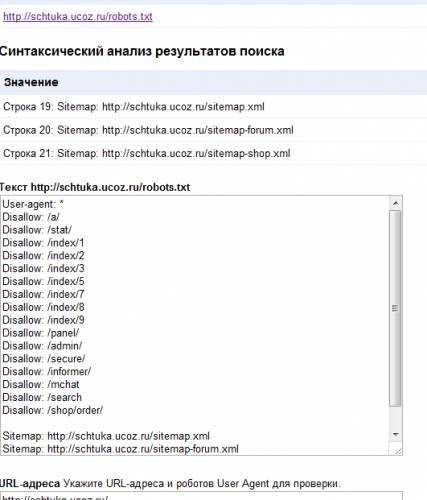

у меня проблема с давних пор моему,все поисковики проиндексировали мой сайт отлично без проблем,но гугл мне выдал,невозможно проиндексировать мой сайт ,он проиндексировал всего лищь 2 страницы сайта ,они находятся в поиске гугл (лично проверял) полюбуйтесь

откуда он взял 1200 страниц недоступных у меня всего лишь страниц 342 мой робот доступен для роботов гугл  он до сих пор он мне пишет,что мой робот.txt не разрешает роботам гугл индексировать мой сайт,а хотя вы видите что запрета в моём роботе никакого нету,лично я думаю это всё из-за того ,что я когда 2 месяца назад был в карантине я пробывал добавлять сайт в гугл и гугл это запомнил,но могу ошибаться. Мой сайт не забанен роботами это я точно знаю проверял специальными службами.что делать? Прикрепления:

4524418.png

(23.0 Kb)

·

7765550.png

(31.5 Kb)

Сообщение отредактировал made2235 - Среда, 03 Авг 2011, 00:49:46

|

|

made2235, А что у вас со стстаусом sitemap.xml ???

Ejikc, Quote Сейчас глянул, яндекс тоже обязательно в подписе к ссылки на сайт пишет дату Сообщение отредактировал Miss_Esq - Среда, 03 Авг 2011, 08:46:21

|

|

made2235,

Quote что я когда 2 месяца назад был в карантине я пробывал добавлять сайт в гугл и гугл это запомнил,но могу ошибаться попробуйте удалить из вебмастера гугла свою карту сайта и потом добавьте снова. Quote он до сих пор он мне пишет,что мой робот.txt не разрешает роботам гугл индексировать мой сайт на главной у вас были или есть какие либо новости? |

|

|

|

TYOM, один из способов читаем как сделать //forum.ucoz.ru/forum/8-21987-4#728799

и в следующий раз читаем названия тем куда пишем, чтобы не переносили |

| |||

Чат сообщества

Чат сообщества